Data Mining im Lieferantenmanagement – ein Umsetzungsbeispiel

Wie kann man Data Mining im Lieferantenmanagement einsetzen und dies auch umsetzen kann

Es wird zwar immer wieder der Begriff des Data Mining als mögliche Form der Datenanalyse verwendet, doch Praxisbeispiele fehlen oft. Aus dem Grund bietet der folgende Blog einen konkreten Überblick zur praktischen Anwendung des Data Mining im Lieferantenmanagement.

Die Verfahren innerhalb der Data Mining Prozesse sind vielfältig. Oft werden Datenanalysemöglichkeiten im Rahmen der Statistik, der künstlichen Intelligenz oder auch der Datenmustererkennung genutzt, um neues Wissen zu generieren. Die 3 verschiedenen Prozesse des Data Mining sind dazu bereits beschrieben worden. Was jedoch bisher nicht betrachtet worden ist, ist ein praxisorientierter Ansatz zur Umsetzung des Data Mining. Im Folgenden wird dazu die Wissensgenerierung und somit die Datenanalyse im Rahmen des Lieferantenmanagements näher betrachtet.

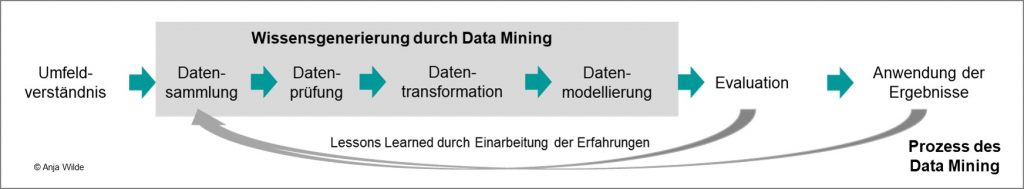

Innerhalb der Literatur werden drei mögliche Data Mining Prozesse postuliert. Diese drei Prozesse decken sich zwar weitgehend bei den Inhalten der einzelnen Prozessschritte, sind jedoch teilweise bei der Anzahl und konkreten Ausgestaltung des Gesamtprozesses different. Somit ist es notwendig, für den Bereich des Lieferantenmanagements einen Best Practice-Prozess zu konzipieren. Dieser Prozess ist in Bild 1 dargestellt. Die Wissensgenerierung, also die Generierung neuer Erkenntnisse, wird dabei durch vier der sieben Prozessschritte des Data Mining repräsentiert. Im Weiteren werden nun alle sieben Prozessschritte näher am Beispiel des Lieferantenmanagements erörtert.

Index

Umfeldverständnis

Ziel im Lieferantenmanagement ist eine effiziente Wissensgenerierung zur frühzeitigen Risikoerkennung in externen Wertschöpfungsnetzwerken. Dafür ist es zunächst wichtig, die Aufgabenstellung für den Data Mining-Prozess zu verstehen. Dies geschieht im Prozessschritt des Umfeldverständnisses. Diesen Prozessschritt beschreiben Cios et al. [1] als Erlangung eines Verständnisses für die betriebswirtschaftlichen Ziele und Anforderungen. Diese werden dann in eine Problemdefinition, die es mit Hilfe des Data Mining zu lösen gilt, verfasst.

Risiken sollen im externen Wertschöpfungsnetzwerk möglichst frühzeitig erkannt werden, damit präventive Maßnahmen eingeleitet werden können. Diese Risiken haben ihren Ursprung in der Lieferanten-Abnehmer-Beziehung. Somit soll innerhalb des Data Mining nach Lieferanten gesucht werden, welche möglicherweise die Anforderungen des Abnehmers nicht erfüllen (potenziell kritische Lieferanten). Bei potenziell kritischen Lieferanten besteht ein erhebliches Versorgungsrisiko [2], was aber nicht zwingend eintreten muss. Allgemein hat jeder Lieferant spezielle Ausprägungen im Rahmen der unternehmensspezifisch festgelegten Kennzahlen. Daraus lassen sich verschiedene lieferantenspezifische Merkmale definieren: leistungsbeschreibende und nicht-leistungsbeschreibende Merkmale.

Leistungsbeschreibende Merkmale haben ihren Ursprung in den dynamischen Daten. Diese dynamischen Daten reflektieren Kennzahlen zur Steuerung der Geschäftsprozesse. Innerhalb einer klassischen Lieferantenbewertung werden bei Leistungsdefiziten oft Muster dieser Merkmale definiert, ab denen ein Lieferant als kritisch gilt. Zusätzlich zu den leistungsbeschreibenden können nicht-leistungsbeschreibende Merkmale für potenziell kritische Lieferanten hinzugezogen werden. Diese Merkmale können dynamisch und auch statisch, d.h. unveränderlich, wie z.B. ein Produktionsstandort, ausgeprägt sein. Zu statischen, nicht-leistungsbeschreibenden Merkmalen können dynamische Risikoereignisse (Streik, politische Unruhen) zugeordnet werden. Im Zuge der Risikobetrachtung werden diese leistungsbeschreibenden und nicht-leistungsbeschreibenden Merkmale in einer Datenbank gesammelt und gespeichert.

Datensammlung

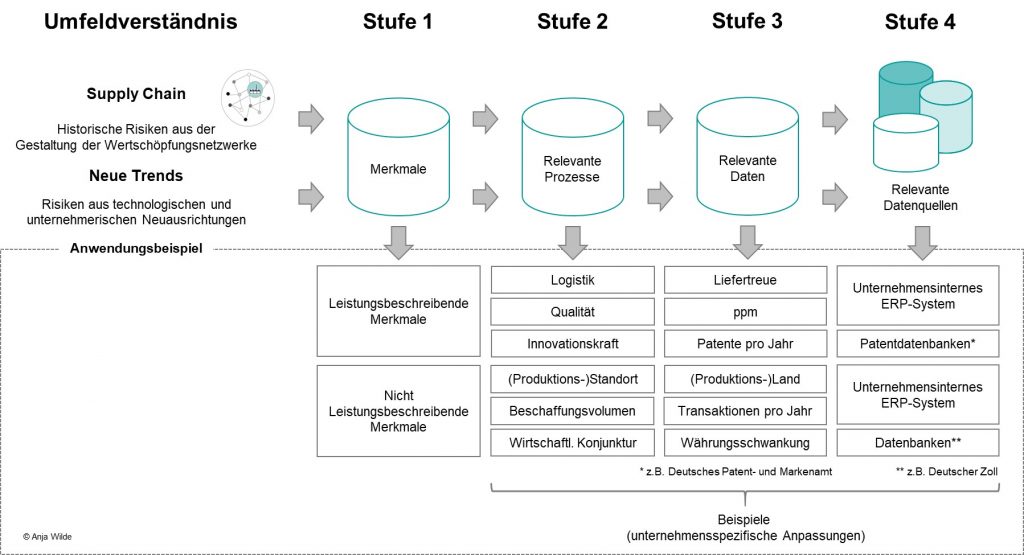

Mit dem Prozessschritt der Datensammlung beginnt der Prozess der Wissensgenerierung. Innerhalb der Datensammlung wird eine Differenzierung der Daten nach ihrer Relevanz für die Aufgabenstellung in Bezug auf das Umfeldverständnis vorgenommen. Die Einteilung von relevanten und nicht-relevanten Daten für die Analyse durch das Data Mining beschreiben Heinz et al. [3] als schwierig. Für das Vorgehen zur Identifizierung relevanter Daten und Datenquellen bietet sich der Prozess von Schmitt et al. [4] an. Dieser Prozess gliedert sich in vier Stufen. Bezogen auf den Data Mining-Prozessschritt des Umfeldverständnis ergibt sich ein gestuftes Vorgehen (Bild 2).

Generisch kann auf Basis dieses Vorgehens jedem lieferantenbezogenen Merkmal eine Datenquelle zugeordnet werden. Es ist jedoch unternehmensspezifisch zu prüfen, welche leistungsbeschreibenden und nicht-leistungsbeschreibenden Merkmale eine Relevanz für den weiteren Prozess aufweisen. Die Kriterien für eine Relevanzprüfung können im Lieferantenmanagement wie folgt ermittelt werden:

- In der Vergangenheit eingetretene Risiken, die anhand von leistungsbeschreibenden und nicht-leistungsbeschreibenden Merkmale identifiziert werden (dokumentierte Risiken)

- Mitarbeiterbefragung, um vermiedene Risiken zu identifizieren (nicht dokumentierte Risiken)

Auf der Basis der Häufigkeit des Eintretens sowie der Bedeutung des Risikos werden die relevanten Risiken und somit auch die entsprechenden leistungsbeschreibenden und nicht-leistungsbeschreibenden Merkmale definiert. An diese Merkmale werden verschiedene Anforderungen gestellt, damit sie auch im weiteren Data Mining-Prozess verwendet werden können:

- Aussagekraft: Das Merkmal muss eine sinnvolle Aussage über einen relevanten Tatbestand bzw. Prozess im Rahmen der Supply Chain Risikobetrachtung enthalten.

- Permanente und stabile Verfügbarkeit: Das Merkmal muss dauerhaft zur Verfügung stehen. Zusätzlich darf sich das Merkmal im Inhalt, wie beispielsweise in Bezug auf die Berechnung einer Kennzahl, nicht verändern.

- Repräsentativität: Repräsentiert ein Merkmal ein Risiko, wird für ein betrachtetes Risiko eine Kennzahl definiert. Zusätzlich muss dieses Merkmal auch eine Aussage über eine repräsentative Grundgesamtheit zulassen.

- Zweckneigung: Das zu betrachtende Merkmal muss zur Lösung der Aufgabe und damit für das entsprechend anzuwendende Analyseverfahren geeignet sein.

Datenprüfung

Die verschiedenen Datenquellen, aus denen die relevante Datenbasis entsteht, weisen eine unterschiedliche, teilweise mangelhafte Qualität der Datensätze auf. Somit muss die Datenbasis auf die gewünschte Datenqualität überprüft werden, um für die weitere Verarbeitung im Data Mining-Prozess genutzt werden zu können [5]. Vossen [6] nennt in dem Zusammenhang zwei Aspekte mangelnder Datenqualität:

- Qualitätsprobleme innerhalb vereinzelter Quellen

- Qualitätsprobleme auf Grund des Datenbankdesigns

Unter mangelnder Datenqualität auf Grund des Datenbankdesigns versteht der Autor beispielsweise Konflikte zwischen Tabellen- und Merkmalsnamen [6]. Aus diesem Grund sollte das Datenbankdesign so gewählt werden, dass eine effiziente Wissensgenerierung möglich ist [7]. Schmitt et al. [4] werden in ihren Ausführungen in Bezug auf Datenqualitätsmängel konkreter. Für sie sind z. B. die Mehrdeutigkeit von Eingabefeldern durch ungenügende Definitionen oder auch einzelne fehlerhafte Daten durch manuelle Eingaben problematisch. Konkrete Ansätze zur Verbesserung der Datenqualität sind bei Wilde [8, 9] zu finden.

Datentransformation

Die Daten werden bei der Datentransformation für die im nächsten Prozessschritt durchzuführenden Analyseverfahren aufbereitet. Dies geschieht bereits mit Hilfe der Auswahl von leistungsbeschreibenden und nicht leistungsbeschreibenden Merkmalen im Rahmen der Datensammlung (Bild 2), die für die Analyseverfahren notwendig sind [10].

Im weiteren Verlauf werden beispielhaft die Verfahren Clusteranalyse, Assoziationsanalyse sowie Relevanzprüfung zur Mustererkennung in Datensätzen eingesetzt. Mit diesen Verfahren ist es im Lieferantenmanagement möglich, Risiken frühzeitig zu erkennen [8]. Diese Verfahren fordern bestimmte Bedingungen zur Datenaufbereitung.

| Verfahren | Smart Data für das Auffinden potenziell kritischer Lieferanten | Datentypen |

| Clusteranalyse | · KPIs mit beliebiger Skalierung | · Metrisch |

| Assoziations- analyse | · Leistungsbeschreibende Merkmale

· Nicht-leistungsbeschreibende Merkmale |

· Metrisch

· Ordinal · Nominal |

| Relevanz- prüfung | · Quantitative Assoziationsregeln | · Metrisch

· Ordinal · Nominal |

Die Datentypen werden dabei wie folgt differenziert [12]:

Metrische Datentypen

Metrische oder auch kardinale Datentypen bestehen aus einer Zahl und sind durch eine Dimension geprägt. Zusätzlich besitzen diese einen absoluten oder natürlichen Nullpunkt. Bei der Arbeit mit einer metrischen Skala sind alle mathematischen Operationen gestattet.

Ordinale Datentypen

Diese Datentypen folgen einem natürlichen Rang n-ter Ordnung. Die Merkmale sind qualitativ geprägt und geben an, ob mit Hilfe des paarweisen Vergleichs eine Alternative größer, gleich oder kleiner als eine andere Alternative ist. Die Einschätzung von Alternativen kann beispielsweise mit „gut“, „mittel“ und „schlecht“ vollzogen werden.

Nominale Datentypen

Die Bewertung erfolgt über Unterschiede durch die Zuordnung von Kategorien. Diese qualitativen Merkmalsausprägungen haben keine natürliche Ordnung. Sie können über „ja“ oder „nein“ bzw. „erfüllt“ oder „nicht erfüllt“ ausgedrückt werden.

Sind alle Daten auf ihre Datenqualität überprüft und transformiert, wird diese Datenbasis mit Hilfe der entsprechenden statistischen Verfahren zur Datenmustererkennung analysiert. Diese Analyse der Datenmuster geschieht im Rahmen der Datenmodellierung.

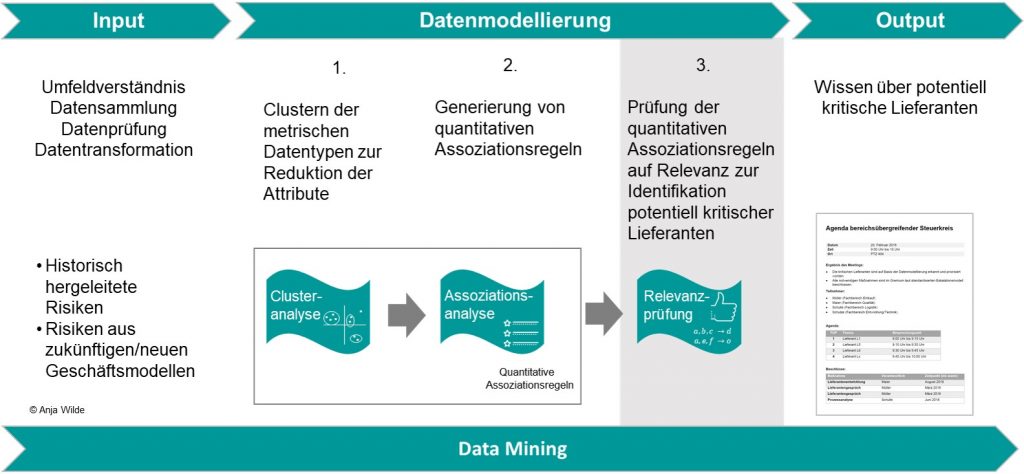

Datenmodellierung

Die Datenmodellierung repräsentiert den Analyseschritt mit Hilfe statistischer Verfahren. Das Ziel ist die Identifizierung von relevanten Assoziationsregeln. Auf Basis dieser relevanten Assoziationsregeln werden die Datenmuster der zugeordneten Lieferanten analysiert, um Wissen über die externen Wertschöpfungsnetzwerke zu erhalten. Um dieses Ziel zu erreichen, wird die Datenmodellierung in der vorliegenden Arbeit in drei statistische Verfahren gegliedert:

- Clusteranalyse

- Assoziationsanalyse

- Relevanzprüfung

Durch die Verbindung der Clusteranalyse mit der Assoziationsanalyse werden quantitative Assoziationsregeln erzeugt.

Die hier dargestellten Verfahren werden in der Literatur hinreichend diskutiert [8, 13, 14]. Als Analyseergebnis der Relevanzprüfung können zusammenfassend drei Zustände festgestellt werden:

Kritische Lieferanten werden auf Basis von vorher gestellten Hypothesen gefunden

Lieferanten die negativ in ihrer Leistungserbringung z.B. in den Bereichen Logistik (Liefertreue) und Qualität (ppm) auffallen, werden als kritische Lieferanten bezeichnet. Diese als kritisch definierten Lieferanten werden einem mandatierten Gremium zur weiteren Maßnahmendefinition gemeldet.

Die quantitative Assoziationsregel hat eine hohe praktische Relevanz.

Nach der Relevanzprüfung werden quantitative Assoziationsregeln mit hoher praktischer Relevanz regelmäßig untersucht. Dabei kann es beispielsweise vorkommen, dass bereits als kritisch definierte Lieferanten mit Weiteren, bisher nicht als kritisch eingestuften Lieferanten einer Regel zugeordnet werden. In diesem Fall wird geprüft, ob die bisher nicht als kritisch eingestuften Lieferanten ebenfalls nun priorisiert betrachtet werden oder nicht. Die Analyseergebnisse im Rahmen der Datenmodellierung dienen als Wissensinput für das mandatierte Gremium zur Definition von Eskalationsmaßnahmen.

Die quantitative Assoziationsregel hat eine geringe praktische Relevanz.

Hat die quantitative Assoziationsregel nach der Relevanzprüfung eine geringe Aussagekraft, geht diese Information in den Data Mining-Prozess ein. Das Ergebnis fließt in die Generierung neuer relevanter, quantitativer Assoziationsregeln ein. Gegebenenfalls ist es zielführend zur Datensammlungsphase zurückzukehren, wenn festgestellt wird, dass sich die gewünschten Ergebnisse nicht mit der genutzten Datenbasis erreichen lassen. Es entsteht ein iterativer und somit lernender Prozess.

Die während der Datenmodellierung genutzten Verfahren gehen nicht der Frage nach, warum eine Implikation eintritt. Vielmehr ist das Ergebnis, dass eine bestimmte Implikation auf eine bestimmte Prämisse folgt. Somit steht auch nur die Auffälligkeit von potenziell kritischen Lieferanten anhand ihrer Zuordnung zu quantitativen Assoziationsregeln und spezifischen Datenmustern im Vordergrund, ohne die Ursache für das Analyseergebnis zu beantworten. Die Ursache für eine entsprechende Auffälligkeit von potenziell kritischen Lieferanten kann auf Basis kausalanalytischer Betrachtungen zusätzlich analysiert werden [15]. Diese kausalanalytischen Betrachtungen sind über experimentelle Langzeitstudien möglich [16].

Evaluation und Anwendung der Ergebnisse

Bisher ist das Wissen zur präventiven Risikoerkennung und der damit verbundenen Steuerung der externen Wertschöpfung generiert worden. Das Wissen fließt in einen Managementprozess ein. Somit sind die mit dem Data Mining verbundenen Schritte der Evaluation sowie der Anwendung der Ergebnisse in den Managementprozess integriert. Mit dieser Integration kann das so entstandene explizite Wissen für die Organisation im Rahmen des Wissensmanagements genutzt werden. Das Thema Wissensmanagement wird im folgenden Blogpost beschrieben.

Literaturverzeichnis

[1] Cios, K. J.; Pedrycz, W.; Swiniarski, R. W.; Kurgan, L. A.: Data Mining. Boston MA: Springer, 2007.

[2] Zobolski, A.: Kooperationskompetenz im dynamischen Wettbewerb. Wiesbaden: Gabler, 2009.

[3] Heinz, K.; Mesenhöller, E.; Grünz, L.: Workflow-Management-Systeme. Dortmund: Verlag Praxiswissen, 2002.

[4] Schmitt, R.; Ngo, Q. H.; Groggert, S.; Elser, H.: Datenbasierte Qualitätsregelung. In: Qualitätsmanagement 4.0 – Status quo! Quo vadis? Hrsg.: Refflinghaus, R.; Kern, C.; Klute-Wenig, S. Kassel: Kassel University Press, 2016, S. 23–42.

[5] Schüller, K.; Fritsch, S.: Wie man Wert aus Smart Data schöpft. In: Herausforderung Utility 4.0. Hrsg.: Doleski, O. D. Wiesbaden: Springer Vieweg, 2017, S. 477–500.

[6] Vossen, G.: Datenmodelle, Datenbanksprachen und Datenbankmanagementsysteme. München: Oldenbourg, 2008.

[7] Tiemeyer, E.; Konopasek, K.: Professionelles Datenbank-Design mit ACCESS. Wiesbaden: Vieweg+Teubner, 1997.

[8] Wilde, M. A.: Supplier Supplier Risk Monitoring – Wissensmanagement als Grundlage einer präventiven Lieferantenbewertung, Berlin, 2020.

[9] Dust, R.; Wilde, A.: Datenqualität im Lieferanten-Risikomanagement. ERP Management (2015) Ausg. 3, S. 35–37.

[10] Chakrabarti, S.: Data Mining. Amsterdam: Morgan Kaufmann, 2009.

[11] Lang, P.; Franke, J.: Datenanalyse. In: Mathematik im Fraunhofer-Institut. Hrsg.: Neunzert, H.; Prätzel-Wolters, D. Berlin: Springer Spektrum, 2015, 65–83.

[12] Heinrich, L. J.; Stelzer, D.; Riedl, R.: Informationsmanagement. Berlin, Boston: De Gruyter, 2014.

[13] Ester, M.; Sander, J.: Knowledge Discovery in Databases. Berlin, Heidelberg: Springer, 2000.

[14] Cios, K. J.; Pedrycz, W.; Swiniarski, R. W.; Kurgan, L. A.: Data Mining. Boston MA: Springer, 2007.

[15] Irlinger, W.: Kausalmodelle zur Lieferantenbewertung. Wiesbaden: Springer Gabler, 2012.

[16] Hettrich, S.; Hippner, H.: Assoziationsanalyse. In: Handbuch Data Mining im Marketing. Hrsg.: Hippner, H. Braunschweig: Vieweg, 2001, S. 459–495.

Die Kommentarfunktion ist geschlossen.