Datenqualität – eine gehasste Liebe im Lieferantenmanagement

Wie kann man das Lieferantenmanagement durch Daten und Datenqualität verbessern?

Es ist wie immer… alle wollen es, alle lieben es, doch keiner will sich darum kümmern. Daten dienen heute mehr denn je als Grundlage für richtungsweisende (Unternehmens-)Entscheidungen. Wir generieren aus Ihnen Informationen und folglich Wissen, um Alternativen abzuwägen und Schlussfolgerungen zu ziehen. Wir steuern ganze (Lieferanten-)Netzwerke auf Basis des generierten Wissens. Umso wichtiger ist es, dass die Qualität dieser Grundlage jederzeit dem höchst möglichen und wirtschaftlich vertretbaren Maß entspricht.

„Die Digitalisierung verändert alle Bereiche eines Unternehmens“ [1]. Der Umgang mit großen Datenmengen sowie der zugehörigen Technologie stellt dabei eine entscheidende Herausforderung dar. „Der gemeinsame Blick aller Akteure eines Unternehmens als auch einer Supply Chain auf die gleiche Datenmenge mit den gleichen Möglichkeiten zur Analyse verbessert die Kommunikation untereinander und führt zu schnellen Entscheidungen“ [1].

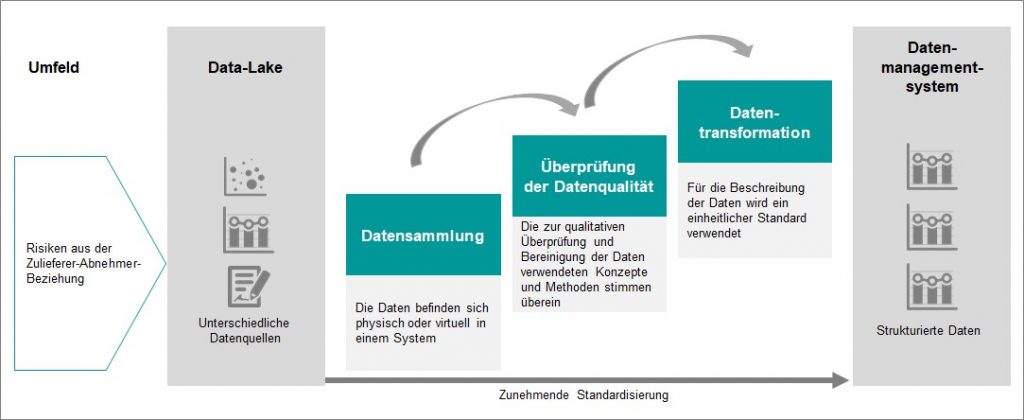

Doch die Entscheidungsgrundlage zur Einleitung von Maßnahmen bei Lieferantendefiziten und drohenden Risiken ist nur so gut, wie die Daten, auf denen das Wissen basiert. Dabei sind die Möglichkeiten der Datenherkunft verschieden. Die Daten aus den verschiedenen Datenquellen sind dabei zunächst unsortiert. Dieses Phänomen der unsortierten Datenmengen wird als Data-Lake (Datensee oder Datenmeer) bezeichnet [2, 3]. Diesen Data-Lake der Big Data gilt es über eine standardisierte Methode für die Wissensgenerierung nutzbar zu machen. Dazu dient die Stufenleiter der Datenintegration (Bild 1).

Index

Ziele und Nutzen einer hohen Datenqualität

Der Wirtschaftswert von Daten für die Unternehmensprozesse wird auf durchschnittlich drei Billionen Dollar pro Jahr über die verschiedenen Branchen geschätzt. Doch die Daten aus den unterschiedlichen Datenquellen haben nicht immer die gewünschte Datenqualität für die Weiterverarbeitung. Liegt nur eine geringe Datenqualität vor, kann dies weitreichende Folgen haben. Oftmals verlassen sich Unternehmen auf die Abläufe in ERP-Systemen, ohne dessen Informationsinhalte zu hinterfragen. Werden diese notwendigen Voraussetzungen nicht geschaffen, können Fehlentscheidungen zu einem ineffizienten Ressourceneinsatz bei der Umsetzung von Maßnahmen führen oder bewirken im ungünstigsten Fall sogar das Unterlassen notwendiger Aktivitäten. Somit kann eine schlechte Datenqualität zu einer falschen Einschätzung der Risikosituation führen. Der Grund: eine Fehlinterpretationen der Ergebnisse [4].

Durch die hohe Datenvielfalt benötigen die Unternehmen neue Modelle zur Absicherung einer validen Datengrundlage. Die Realität wird oftmals nur unvollständig abgebildet. Die Ursachen schlechter Datenqualität sind in diesem Zusammenhang vielfältig [4]. Fehlerquellen im Zieldatenbestand können fehlende Werte oder aber auch Redundanzen sein.

Eine robuste Qualität der Datenbasis ist beispielsweise für die Analyse relevanter Datenmengen im Rahmen des Data Mining von hoher Bedeutung. Die Daten sollten vor der Analyse auf Fehler, Ausreißer oder Rauschen untersucht und bereinigt werden [5]. Die spezifischen Definitionen des Begriffes der Datenqualität sind stark subjektiv geprägt [4]. Helfert [6] diskutiert dazu spezifische Ansätze. Eine allgemeine Formulierung finden Heinrich et al. [7]. Dabei wird die Datenqualität als „Gesamtheit der Merkmale von Daten[, die] bezüglich ihrer Eignung, festgelegte und vorausgesetzte Erfordernisse […] erfüllen“ [7] definiert. „Diese Eignung kann sich über die Zeit ändern, wenn sich Bedürfnisse ändern“ [8]. Diese Erfordernisse, d.h. die Qualitätsmerkmale, müssen festgelegt werden.

Auch die Definitionen von Qualitätsmerkmalen sind in der Literatur vielfältig [5, 6]. Heinrich et al. [7] postulieren beispielsweise Richtigkeit, Vollständigkeit, Genauigkeit, Relevanz und Nutzen. Apel et al. [4] fügen dazu die Schlüsseleindeutigkeit über den Primärschlüssel sowie die referenzielle Integrität hinzu. Schendera [9] weißt der Datenqualität hingegen unter anderem Missings, Einheitlichkeit sowie Plausibilität zu. Helfert [6] fasst in seiner Abhandlung weitere ausgewählte Ansätze, welche bis 2001 publiziert worden sind, in Bezug auf die Datenqualität zusammen.

Ein generisches Modell

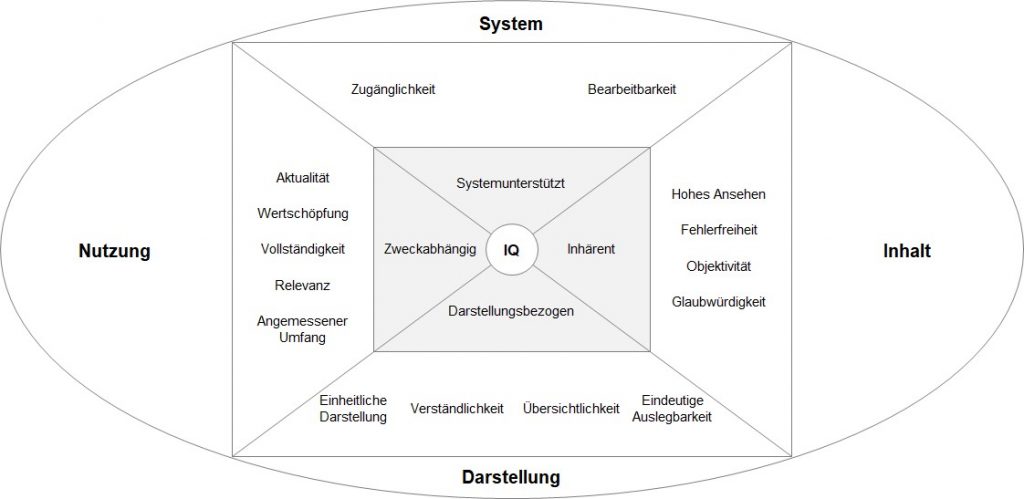

Aus verschiedenen Studien zum Thema Datenqualität entwickelte die Deutsche Gesellschaft für Informations- und Datenqualität (DGIQ) folgendes Qualitätsmodell:

Wie beschrieben, sind die Modelle der Darstellung von Datenqualitätsmerkmalen in der Literatur vielfältig. Drei Kriterien haben sie jedoch gemeinsam [5, 9, 10]:

- Vollständigkeit

- Aktualität, Zeitnähe, Zeitbezug

- Relevanz

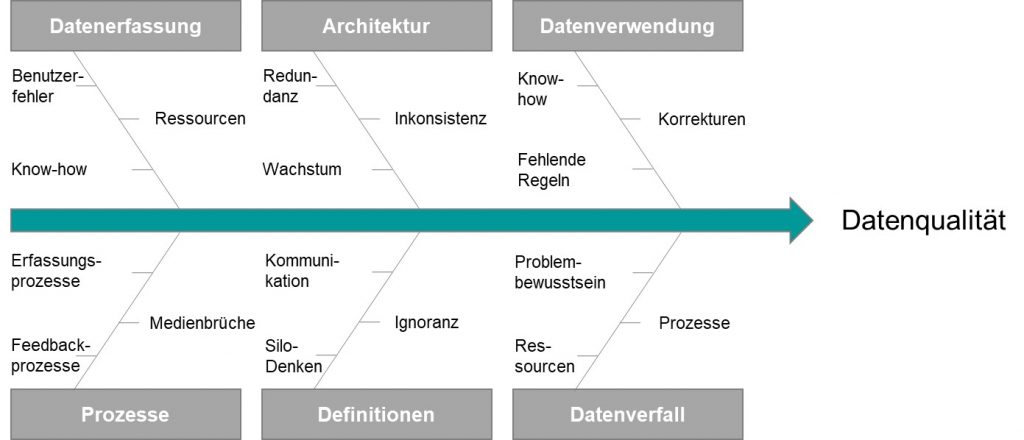

Sind die spezifischen Datenqualitätsmerkmale, je nach Anwendung, nicht erfüllt, wird von einer schlechten Datenqualität gesprochen. Apel et al. [4] haben dazu die möglichen Ursachen einer schlechten Datenqualität zusammengetragen. Unterteilt werden diese in sechs Hauptkategorien (Bild 3) [4].

Diese Ursachen können teilweise frühzeitig verhindert werden. Beispielsweise können die Prozesse zur Datensammlung so gestaltet werden, dass es keine Systembrüche gibt. Manuelle Eingabefehler werden somit ausgeschlossen. Dies kann durch Schnittstellen zwischen den verschiedenen Medien oder Systemen gewährleistet werden.

Weißt die Datenbasis eine schlechte Datenqualität auf, kann dies verschiedene Konsequenzen haben. Diese Konsequenzen einer schlechten Datenqualität beschreibt Schendera [9] wie folgt:

- „Jede Abweichung von einer perfekten Datenqualität ist immer eine suboptimale Datenqualität.“

- „Eine suboptimale Datenqualität ist dabei immer mittels der vorgebrachten subjektiven Gründe, Kriterien oder Ursachen seitens der Anwender zu erklären bzw. zu verantworten.“

- „Eine (sub)optimale Datenqualität ist kein Selbstzweck, sondern eine Eigenschaft mit Folgen.“

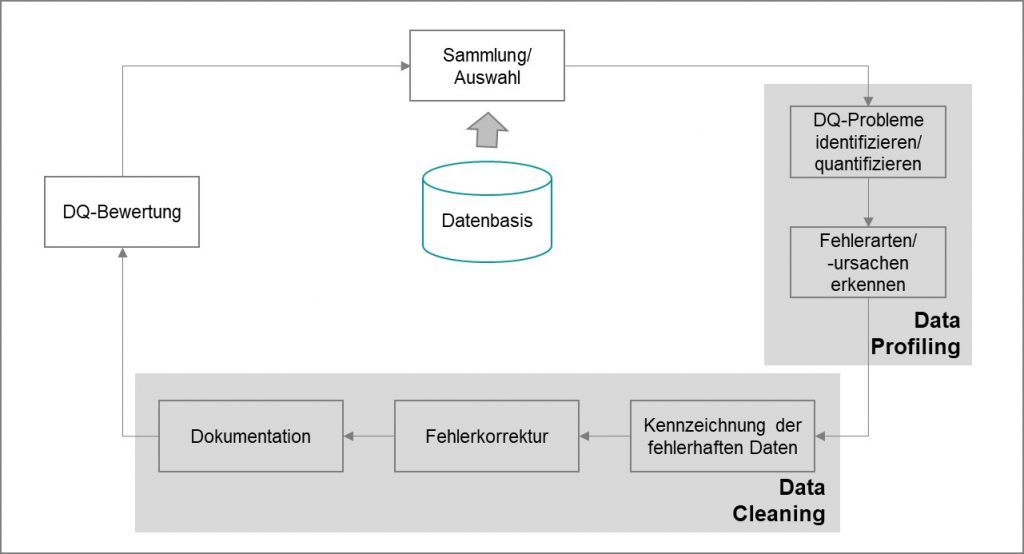

Um diese Konsequenzen einer schlechten Datenqualität zu verhindern, ist es notwendig, die Datenqualität sicherzustellen. Wenn frühzeitige Maßnahmen zur Datenqualitätssicherung nicht ausreichen, muss ein Prozess zur Datenprüfung und -bereinigung definiert werden. Die spezifische Strategie zur Bereinigung der Datenbasis ist je nach Anwendung verschieden. Allgemein kann jedoch der Prozess des Data Profiling und des Data Cleaning zur Sicherung der Datenqualität festgehalten werden [5, 10].

Zur Bereinigung der Daten und somit zur Sicherung der Datenqualität werden zunächst die zu verwendenden Daten aus der Datenbasis ausgewählt. Danach beginnt der Prozess des Data Profiling. Wird nur dieser Prozess separiert, gliedert er sich nach Apel et al. [4] in folgende Schritte:

- Schritt 1: Integration der Daten – Sammlung und Auswahl der relevanten Daten, die für den Data Profiling-Prozess genutzt werden sollen.

- Schritt 2: Analyse der integrierten Daten – Fehlerarten und -ursachen werden durch verschiedene konzeptionelle, formale, statistische und logische Analyseverfahren erkannt.

- Schritt 3: Ergebnisdarstellung – Die Ergebnisse, die Fehlerarten und -ursachen, werden anhand der Analyse erkannt und aufbereitet.

- Schritt 4: Bewertung der Ergebnisse – Die Ergebnisse werden durch ein Data Profiling-Team bewertet.

Durch den reinen Prozess des Data Profiling werden die Daten mit einer niedrigen Datenqualität jedoch noch nicht bereinigt. Dafür ist der Prozess des Data Cleaning zuständig. Fehlerhafte Daten werden zunächst gekennzeichnet. Die gekennzeichneten Daten werden daraufhin korrigiert und die Ergebnisse dokumentiert. Unter dem Prozess der Fehlerkorrektur verstehen Apel et al. [4] die Bereinigung der fehlerhaften Daten. Die Bereinigung der fehlerhaften Daten findet je nach Fehler beispielsweise durch Zurückhaltung, Abweisung oder Bereinigung der Daten statt. Die Gesamtergebnisse aus Data Profiling und Data Cleaning werden wiederum bewertet. Die korrigierten Daten gehen dann in die Datenbasis ein oder werden für weitere Analysen genutzt.

Was kostet es – was bringt es?

Eine Kosten-Nutzen-Überlegung zum Thema Datenqualität strengt Schendera [9] an. Das Ergebnis dieser Erörterung sind folgende Aussagen des Autors:

- Der Aufwand zur Steigerung der Datenqualität lohnt sich, da „Daten mit höherer Qualität […] genauer und interpretierbarer [sind]“ [9].

- „Jede Ungenauigkeit [innerhalb der Daten] kostet bares Geld“ [9], wenn Managemententscheidungen und Strategien auf Basis falschen Wissens beschlossen werden.

- „Datenqualität schützt somit auch vor Fehlverhalten und Fehlinvestitionen.“ [9]

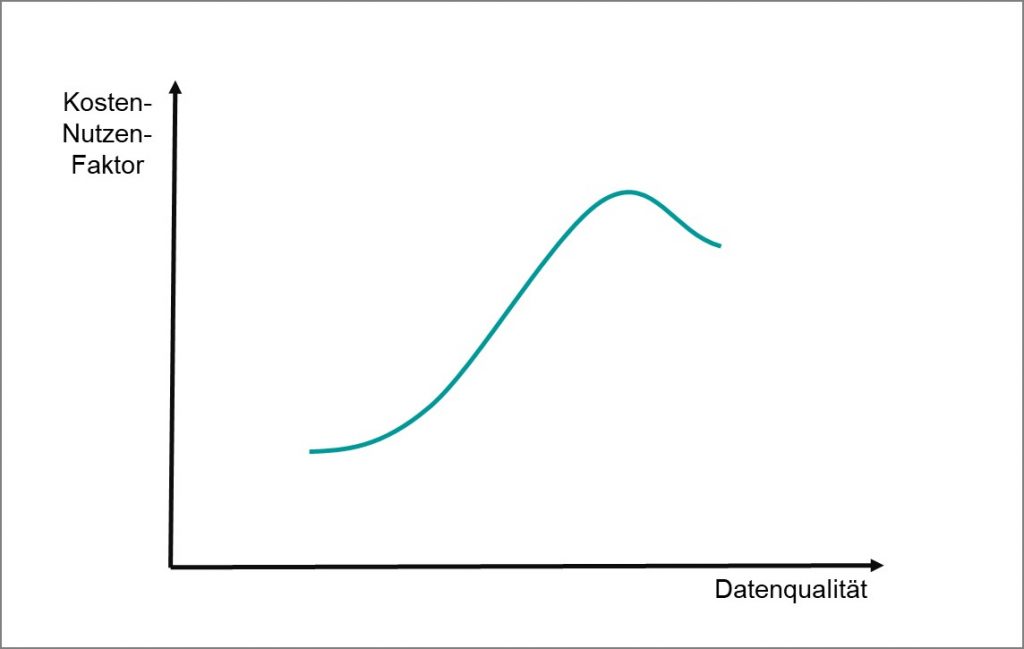

Somit kann eine schlechte Datenqualität Kosten bei darauf basierenden Fehlentscheidungen verursachen. Doch auch die Steigerung der Datenqualität ist mit einem Aufwand verbunden. Harrach [11] publiziert in diesem Zusammenhang den Kosten-Nutzen-Faktor der Datenqualität (Bild 5).

Bild 5 Kosten-Nutzen-Faktor der Datenqualität – Quelle: Eigene Darstellung

Der Gesamtwert einer guten Datenqualität ist in Abhängigkeit zu den dafür verursachenden Kosten dargestellt. Um alle Mängel der Datenqualität zu beseitigen, werden systematische und unsystematische Fehler betrachtet und bereinigt. Doch auch Harrach [11] konstatiert, dass sich der direkte monetäre Nutzen der Datenqualität nur schwer nachweisen lässt. Diese Aussage ist jedoch sehr pauschal und nicht auf einen speziellen Anwendungsfall bezogen. Apel et al. postulieren, dass für das Data Mining eine besonders hohe Datenqualität notwendig ist, „damit es nicht zu Fehlinterpretationen [der Ergebnisse] kommt“ [4]. Wissenschaftliche Untersuchungen zu einer Kosten-Qualitätsbetrachtung im Rahmen der Datenqualität stehen bisher jedoch noch aus. Apel et al. [4] sprechen in dem Zusammenhang von Szenarien, die entsprechend priorisiert werden sollen, ohne jedoch auf die Art der Szenarien noch auf die Aussage der Priorität einzugehen. Auch Cordts [12] behandelt die Analyseverfahren, die zu einer hohen Datenqualität führen und Quatemberger [13] betrachtet die Datenqualität bei der Erhebung von Stichproben. Beide Autoren analysieren und beurteilen den Kosten-Nutzen-Vergleich einer hohen Datenqualität nicht. Lediglich Block [14] beschreibt einen Ansatz zur Messung des Einflusses der Datenqualität auf einzelne Kennzahlen über „Gewichts- und Messmatrizen“. Der Einflussfaktor der Datenqualität auf die jeweilige Kennzahl wird subjektiv nach „hoch, mittel und niedrig“ gewählt. Zusätzlich zu den Matrizen werden Korrekturmaßnahmen für eine unzureichende Datenqualität erörtert. Wie hoch jedoch die ideale Datenqualität sein soll, um einen kennzahlenspezifischen Kosten-Nutzen-Faktor zu ermitteln, bleibt auch in dieser Publikation offen.

Quellen zum nachlesen

[1] Fraunhofer IML; BME e.V.: Einkauf 4.0 – Digitalisierung des Einkaufs. Dortmund, Frankfurt, 2016.

[2] Stahl, R.; Staab, P.: Die Vermessung des Datenuniversums. Berlin: Springer Vieweg, 2017.

[3] Werner, H.: Supply Chain Management. Wiesbaden: Springer, 2017.

[4] Apel, D.; Behme, W.; Eberlein, R.; Merighi, C.: Datenqualität erfolgreich steuern. Heidelberg: dpunkt., 2015.

[5] Windt, K.; Knollmann, M.; Meyer Mirja: Anwendung von Data Mining Methoden zur Wissensgenerierung in der Logistik – Kritische Reflexion der Analysefähigkeit zur Termintreueverbesserung. In: Wissensarbeit. Hrsg.: Spath, D. Berlin: GITO, 2011, S. 223–249.

[6] Helfert, M.: Planung und Messung der Datenqualität in Data-Warehouse-Systemen. Bamberg, 2002. URL: http://dataquality.compu ting.dcu.ie/thesis/(German).Markus.Helfert.thesis.2002.pdf (Zugriff: 2017-09-06).

[7] Heinrich, L. J.; Stelzer, D.; Riedl, R.: Informationsmanagement. Berlin, Boston: De Gruyter, 2014.

[8] Würthele, V.G.: Datenqualitätsmetrik für Informationsprozesse. Zürich, 2003. URL: http://e-collection.ethbib.ethz.ch/cgi-bin/show.pl?type= diss&nr=15242 (Zugriff: 2017-06-12).

[9] Schendera, C. F. G.: Datenqualität mit SPSS. München: Oldenbourg, 2007.

[10] Gomez, J. M.; Rautenstrauch, C.; Cissek, P.; Grahlher, B.: Einführung in SAP Business Information Warehouse. Berlin, Heidelberg, New York: Springer, 2006.

[11] Harrach, H.: Risiko-Assessments für Datenqualität. Wiesbaden: Vieweg, 2010.

[12] Cordts, S.: Datenqualität in Datenbanken. Heide: Mana-Buch, 2012.

[13] Quatember, A.: Datenqualität in Stichprobenerhebungen. Berlin: Springer Spektrum, 2014.

[14] Block, F.: Verknüpfung von DG-Indikatoren mit KPIs und Auswirkungen auf das Return on Invest. In: Daten- und Informationsqualität. Hrsg.: Hildebrand, K. et al. Wiesbaden: Springer Vieweg, 2018, 393–414.

Die Kommentarfunktion ist geschlossen.