Voici comment la technologie nous change et nous divise – Un monde plein d’extrêmes

Bulles de filtrage et radicalisation - la technologie nous changera à jamais

L’internet et les plateformes de médias sociaux ont un impact important sur nos vies et ils pourraient même nous changer et nous diviser à bien des égards. Que sont les préjugés, les bulles de filtres et pourquoi les plateformes de médias sociaux tentent-elles de nous diviser ?

La technologie peut être considérée comme un miracle des temps modernes, mais nous divise-t-elle ? Il y a à peine deux siècles, nous ne pouvions même pas imaginer que nous pourrions prendre l’avion, il n’y avait aucune possibilité d’appeler quelqu’un ou même d’avoir une vidéoconférence où l’on partage un document en même temps. Cette évolution de l’ordinateur et de l’internet a eu de nombreux effets sur notre vie quotidienne.

L’internet nous a permis de nous connecter, de partager et d’interagir par le biais de plateformes de médias sociaux, de rechercher des informations en ligne et de consommer du contenu sans limites. D’une certaine manière, il a donné un coup de fouet à nos interactions sociales d’une toute nouvelle manière. Nous nous sommes habitués à faire défiler, à naviguer, à glisser et à tapoter dans le monde virtuel sans limites et avec un contenu sans fin généré par des personnes que nous aimons, admirons, adorons ou même envions.

Mais toutes ces connexions, ces possibilités et cette abondance d’informations ont aussi des conséquences. Nous sommes extrêmes lorsqu’il s’agit de choisir nos partenaires, car des applications comme Tinder nous donnent l’impression qu’il suffit d’un glissement de souris de plus pour trouver un partenaire encore meilleur, Instagram nous présente un monde parfait où les gens ne sont qu’heureux, riches et prospères, et les filtres nous donnent l’impression que seuls un visage, un corps et des vacances parfaits sont la norme. Nous sommes bombardés de fake news, nous sommes piégés dans un monde où nous ne voyons que le contenu qui nous correspond le mieux et nous ne sommes même connectés qu’avec des personnes qu’un algorithme choisit pour nous.

Ces conséquences entraînent également une fracture dans notre société.

Index

Le problème des médias sociaux

Pour comprendre le dilemme sous-jacent des médias sociaux, nous devons comprendre les mécanismes qui les sous-tendent et leur modèle économique. Tout d’abord, nous devons comprendre que les utilisateurs sont le produit. Toute personne utilisant des plateformes comme Facebook, Twitter, etc. accepte d’être analysée et de voir des publicités. Par conséquent, les plateformes tentent de maximiser le temps que vous passez sur la plateforme, en essayant d’utiliser des techniques de manipulation qui créent de l’anxiété dans votre cerveau pour vous garder accroché au contenu afin que vous restiez plus longtemps sur la plateforme et consommiez plus de contenu pour pouvoir vous montrer plus de publicité.

Les principaux objectifs des plateformes de médias sociaux sont les suivants :

- Obtenir le maximum d’informations sur un utilisateur, sa vie, son niveau de vie, etc.

- Amener l’utilisateur à partager plus de contenu

- Amener l’utilisateur à consommer plus de contenu

- Amener l’utilisateur à interagir avec d’autres contenus

- Amener l’utilisateur à inviter d’autres utilisateurs

- Amener l’utilisateur à interagir avec les publicités

- Accroître la notoriété de la marque

Deuxièmement, nous devons comprendre que le seul véritable client des plateformes de médias sociaux est constitué par les annonceurs payants. Toutes les plateformes de médias sociaux essaient d’optimiser leurs résultats. Ainsi, vos données, votre temps et vos interactions devraient être monétisés en vous incitant à aller dans la bonne direction (eng. Nudging) pour que vous changiez d’avis, que vous achetiez quelque chose ou que vous soyez plus enclin à faire quelque chose. Cette influence sur vous et votre décision est la valeur qui peut être monétisée pour les fournisseurs de plateformes de médias sociaux.

Les fausses nouvelles (Fake News) font partie du problème

Rien n’est plus ennuyeux que les nouvelles qui ne sont pas « activantes » ou « controversées ». Le contenu dit « appât à cliquer » est un contenu qui tente activement d’activer les régions de notre cerveau où se produit la « peur de manquer ». Ce contenu est spécialement conçu pour avoir l’air extrême, super intéressant ou super controversé afin que de nombreuses personnes cliquent dessus. Pour cela, vous devez aussi réaliser que les clics sont comme l’étalon-or sur Internet. Plus vous attirez l’attention, plus le média, l’influenceur et la plateforme ont du succès.

Mais la chasse au contenu controversé qui entraîne beaucoup de discussions, de partages et d’interactions est aussi une chasse aux fausses nouvelles. Nous avons vu beaucoup de fausses affirmations devenir virales lorsque de nombreuses personnes les partagent et les poussent sur Internet, mais d’un autre côté, la « vérité ennuyeuse » arrive à peine dans le top 10 des lectures.

Même Facebook, Google et d’autres plates-formes se battent avec acharnement pour détecter et éliminer les fake news, mais la vérité est qu’ils veulent les avoir sur leur plate-forme car cela augmente la rétention des utilisateurs et les taux d’interaction avec la plate-forme.

Bulles de filtre (« Filter Bubbles ») expliquées

Pour comprendre pourquoi nous pouvons être la cible de ce type de contenu et pourquoi nous ne voyons parfois que du contenu similaire, nous devons comprendre le concept de « bulle de filtrage ». Il s’agit d’un terme couramment utilisé pour décrire une situation dans laquelle seul un contenu pré-filtré est présenté dans l’univers unique d’informations dans lequel vous vivez en ligne. Ainsi, vous ne voyez dans votre ligne temporelle que le contenu spécifique qui vous a intéressé ou avec lequel vous avez interagi.

Par exemple, si vous regardez plusieurs jours de suite des vidéos de bricolage sur Facebook, vous verrez soudainement de nombreuses vidéos de bricolage, du contenu et des suggestions de pages dans votre timeline. Pour que cela se produise, d’autres contenus sont repoussés ou même supprimés de votre liste de contenus. Les plateformes de médias sociaux tentent d’optimiser parfaitement cette bulle de filtrage afin de vous faire rester plus longtemps sur Internet.

Voici maintenant le problème. Imaginez que vous voyez un post controversé où quelqu’un a publié des fake news et que vous essayez simplement de faire comprendre que c’est faux et que vous partagez par exemple une source fiable. L’algorithme pense alors que vous aimez ce contenu parce que vous avez interagi avec lui. Le jour suivant, vous voyez deux de ces messages et le jour d’après encore plus. Tout à coup, vous vous retrouvez dans une bulle de filtres où vous ne voulez pas être et vous commencez à voir les nouvelles et même les messages d’une manière biaisée parce que soudainement vous n’interagissez qu’avec un certain groupe de personnes.

Fracture sociale – Création de préjugés

Lorsque nous ne voyons que les mêmes personnes avec les mêmes croyances, nous commençons à penser inconsciemment que cela est juste. C’est aussi pourquoi les algorithmes ne présentent les blancs qu’aux blancs, les femmes qu’aux femmes, et donc vous obtenez des biais dans votre monde.

Un bon exemple est Instagram. Cette application est l’un des rois de l’optimisation de votre flux en fonction de vos goûts. Si vous aimez les grandes femmes blondes, vous ne verrez qu’un monde rempli de grandes femmes blondes. Lorsque vous ne recherchez que des citations motivantes, tout vous rappellera de réussir et comment les riches vivent leur vie. Cela nous pousse à avoir de nombreux préjugés et façonne même la façon dont nous voyons le monde en dehors des médias sociaux.

Radicalisation en politique

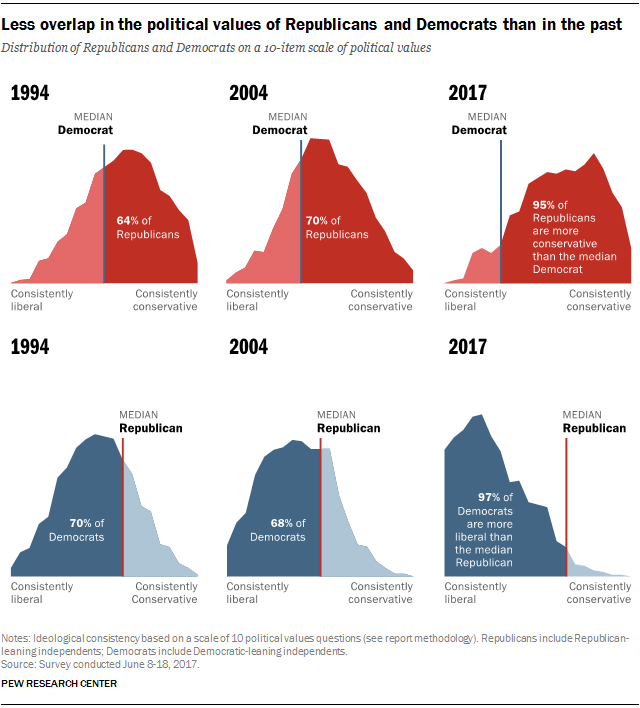

Un bon exemple dans la vie réelle est toujours la politique, car elle est largement influencée par votre entourage et par les informations que vous consommez. Pendant des siècles, le système bipartisan des États-Unis a toujours fait pencher les deux partis vers le centre et les idées libérales. Le Pew Research Center a mené des enquêtes en 1994, 2004 et 2017 et a constaté que l’opinion libérale est remplacée par des opinions radicales sur les 10 principales politiques. Ce phénomène est également attribué en grande partie aux médias sociaux et à l’interaction avec le contenu dans des bulles de filtres.

Lorsque vous êtes bombardé de fausses nouvelles sur des étrangers voleurs, violeurs et criminels, vous commencez à croire qu’ils sont réellement des criminels. Cela conduit à une vision plus radicale et, en fin de compte, à un comportement électoral plus radical. (Bien sûr, il en va de même dans l’autre sens).

{%CAPTION%}

Comment échapper à cette bulle filtrante ?

Il existe quelques astuces pour éliminer certains effets de votre bulle de filtre afin d’obtenir au moins plus d’opinions et un contenu plus diversifié dans votre flux.

- Suivez des personnes ayant une opinion totalement différente

Recherchez activement des personnes qui n’ont pas la même opinion et qui pourraient ajouter quelque chose de totalement différent à votre flux. Cela vous aidera à avoir une vision diversifiée. - Parcourez les flux d’autres personnes

Recherchez des personnes intéressantes dont vous n’avez jamais entendu parler et essayez de faire défiler leur flux pour voir différentes opinions et ce qu’elles ont « filtré ». - Filtrez activement votre flux

Avec chaque article, vous pouvez dire que vous voulez voir moins de ces suggestions. En général, dans les post-options (menu à 3 points, etc.), vous pouvez dire « Je veux voir moins de ce contenu ». Cela vous aidera à façonner votre flux de contenu et peut-être même à y apporter du contenu plus utile. - Faites des recherches

Il est généralement difficile de trouver de véritables preuves. Mais si vous avez l’impression que quelque chose n’est là que pour servir d’appât à clics, faites des recherches pour savoir si c’est vraiment vrai ou bloquez-le simplement comme indiqué dans l’astuce précédente.

Verdict – Les dangers d’un monde radical

Nous sommes liés à un monde où les médias sociaux remplacent peu à peu nos contacts sociaux physiques. Nous n’avons jamais consommé autant de contenu qu’aujourd’hui et nous devons prendre conscience que nous sommes utilisés. Les plateformes telles que Facebook, Twitter, etc. tentent d’optimiser la façon dont elles peuvent diriger, orienter et influencer et nous devons être conscients de ce qui se passe, afin d’avoir une petite chance de le contrecarrer.

Bien sûr, nous ne pouvons pas simplement abandonner tous les canaux de médias sociaux, mais nous devons adopter une approche très différente de la consommation de ces services. Nous devons être conscients que tout ce que nous voyons n’est que du contenu « optimisé » parfait, que nous restons dépendants de ce contenu et que nous passons le plus de temps possible à le faire défiler et à en rechercher de nouveaux. Cette économie de l’attention sera toujours là, car la boîte de Pandore a déjà été ouverte et nous devons simplement apprendre à y faire face par nous-mêmes.

Sans certaines réglementations politiques et sans limiter notre consommation médiatique en tant que société, nous sommes seuls à décider du contenu que nous consommons, de la durée de notre interaction et si nous croyons tout ce qui nous est présenté en ligne.

Comments are closed.