Large Language Models (LLMs) sicher im Unternehmen nutzen

Vom KI-Hype zur praktischen Umsetzung der Large Language Modelle

Wie können Unternehmen Large Language Modelle optimieren und gleichzeitig ihre sensiblen Daten intern halten? Ziel dieses Artikels ist es, Ansätze für die Analyse unstrukturierter, unternehmensinterner Daten aufzuzeigen und gleichzeitig den Anforderungen des Datenschutzes gerecht zu werden.

Index

ChatGPT war ein Eye Opener

Mit der Einführung von ChatGPT wurde in der allgemeinen Wahrnehmung nicht nur ein neues Kapitel der Künstlichen Intelligenz (KI) aufgeschlagen, einige Autoren sprechen sogar von der fünften industriellen Revolution. Eine der aufregendsten Entwicklungen in diesem Bereich ist der Einsatz von Large Language Models (LLMs), wie z.B. GPT3.5 von OpenAI, um Aufgaben der natürlichen Sprachverarbeitung zu automatisieren und zu verbessern. Im digitalen Zeitalter ist der Einsatz von künstlicher Intelligenz und maschinellem Lernen für Unternehmen von entscheidender Bedeutung, um wettbewerbsfähig zu bleiben.

Vom KI-Hype zur praktischen Umsetzung

Doch wie können Unternehmen diese Modelle optimieren und gleichzeitig ihre sensiblen Daten intern halten? Ziel dieses Artikels ist es, Ansätze für die Analyse unstrukturierter, unternehmensinterner Daten aufzuzeigen und gleichzeitig den Anforderungen des Datenschutzes gerecht zu werden.

Große Sprachmodelle werden über Jahre mit unvorstellbar großen Datenmengen und enormem Rechenaufwand trainiert. Das Prinzip dahinter: Mithilfe von Algorithmen werden gespeicherte Wörter in einem n-dimensionalen Vektorraum nach den Prinzipien der Statistik und Wahrscheinlichkeit durchsucht. So wird ein Wort für Wort das nächste passende Wort zur Frage gefunden und als Antwort zusammengesetzt.. LLMs sind also leistungsfähige Werkzeuge, die natürliche Sprache verstehen und generieren können. Allerdings können diese Modelle nicht „out of the box“ optimal funktionieren. Sie haben keinen eigenen Verstand oder echtes Verständnis für die Welt wie ein menschliches Gehirn.

Interne Daten als Schlüssel zum Erfolg

Der Erfolg bei der Optimierung von LLMs in Unternehmen beginnt mit dem internen Fach- und Domainwissen. Die Mitarbeitenden in verschiedenen Abteilungen verfügen über ein tiefes Verständnis der Unternehmensprozesse, der Zielgruppen und der spezifischen Anforderungen. Dieses Wissen ist von unschätzbarem Wert bei der Anpassung von LLMs. Um die besten Ergebnisse zu erzielen, müssen sie an den spezifischen Kontext und die individuellen Anforderungen eines Unternehmens angepasst werden. Fine-Tuning und Retrieval Augmented Generation (RAG) sind zwei Methoden, um die Leistung von Large Language Models (LLMs) zu verbessern:

- Fine-Tuning ist ein Prozess, bei dem ein vorhandenes LLM auf eine spezifische Aufgabe trainiert wird, indem es mit spezifischen Daten angepasst wird. Fine-Tuning erfordert jedoch eine große Menge an Daten, um effektiv zu sein.

- Retrieval Augmented Generation (RAG) [i] hingegen nutzt externe Wissensquellen, um die Qualität der vom LLM generierten Antworten zu verbessern. RAG basiert auf einem Information-Retrieval-System, das auf Datenbanken basiert. Das LLM wird dann verwendet, um die abgerufenen Informationen zu verarbeiten und die Antwort zu generieren.

Retrieval Augmented Generation

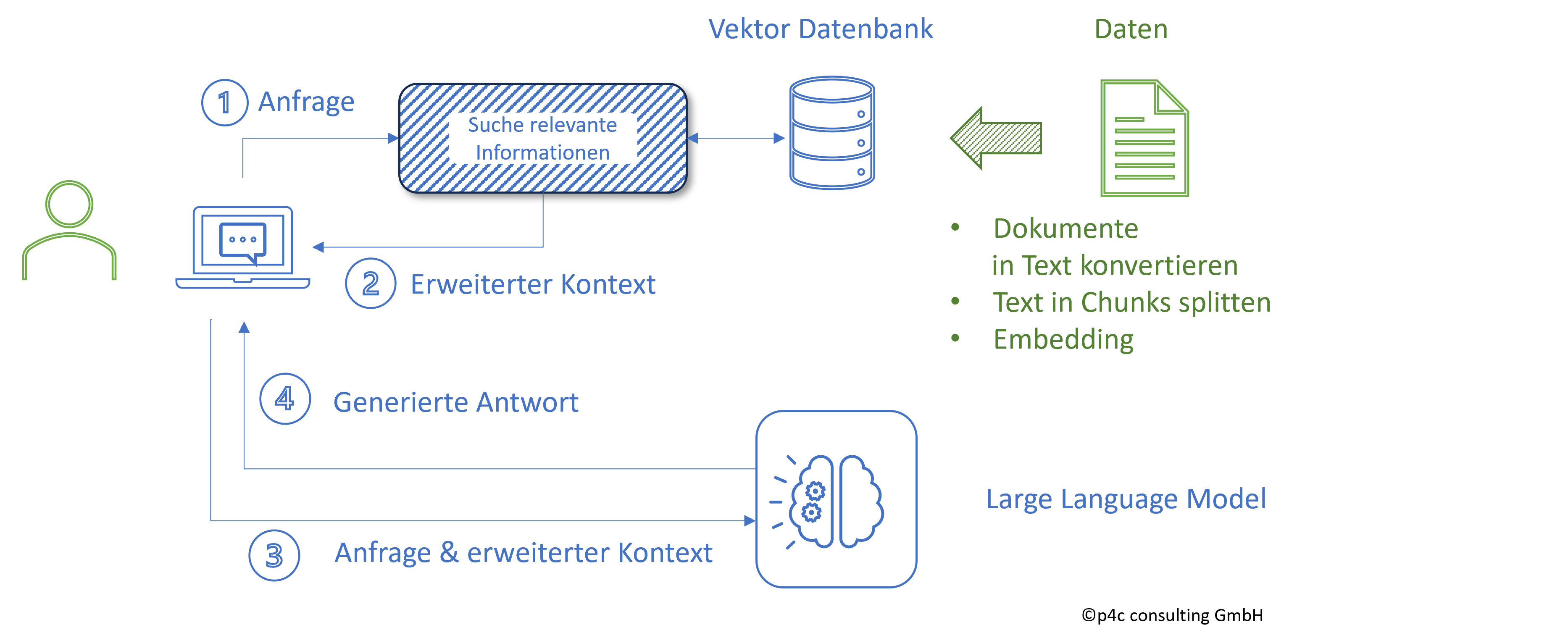

Retrieval Augmented Generation (RAG) stellt derzeit eine vielversprechende Möglichkeit dar, eigene Daten sicher in ein LLM zu integrieren. Dabei wird die begrenzte Menge an Inhalten pro Anfrage (Tokenlänge) berücksichtigt. In einem vorgeschalteten eigenen KI-Modell werden jeweils die für die Beantwortung der Frage relevanten eigenen Dokumentteile ermittelt – und diese Fragmente als erweiterter Kontext mit der Anfrage an das LLM geliefert.

- Die Anfrage wird genutzt, um mithilfe einer Ähnlichkeitssuche in der Vektordatenbank nach relevanten Informationen zu suchen.

- Die Anfrage wird um relevante Informationen erweitert.

- Die erweitere Anfrage wird an das LLM übergeben.

- Das LLM generiert eine unternehmensspezifische Antwort auf die Anfrage.

(Vgl. Abb. 1)

Vektordatenbanken als Schlüsselwerkzeug

Vektordatenbanken sind eine fortschrittliche Technologie, mit der Unternehmen interne unstrukturierte Daten effizient organisieren und abrufen können. Ein großer Vorteil von Vektordatenbanken ist ihre Fähigkeit, semantische Beziehungen zwischen Begriffen zu erfassen. Sie verwenden Vektorrepräsentationen von Textdaten, um eine effiziente Ähnlichkeitssuche und -analyse zu ermöglichen.

Zunächst werden die verschiedenen Dokumentenformate mit ihren unstrukturierten Daten eingelesen. Das können z. B. PDFs, verschiedene Textformate (.docx, .txt) oder auch Webtexte (.html) sein. Anschließend wird der Text eines eingelesenen Dokuments in sogenannte Chunks zerlegt, die hunderte bis mehrere tausend Zeichen umfassen können. Damit der Kontext, bzw. der Sinn eines Textes nicht verloren geht oder verfälscht wird, werden die Chunks um einige Zeichen überlappt. Beim Embedding geht es nun darum, die Texte der Chunks mit anderen Texten oder Chunks vergleichbar zu machen. Dies geschieht durch die Umwandlung der Texte in jeweils eindeutige numerische Vektoren. Zu diesem Zweck werden sogenannte Embedding-Modelle verwendet. Es gibt eine Reihe von Open-Source-Embedding-Modellen, die verwendet werden können. Einige der bekanntesten Modelle sind:

- BGE

- FastText

- Word2Vec

- GloVe

- Sent2Vec

Datenschutz und Sicherheit gewährleisten

Ein entscheidender Faktor bei der Optimierung von LLMs in Unternehmen ist der Schutz sensibler Daten. So wichtig es ist, internes Fach- und Domänenwissen im Unternehmen zu halten: Es muss auf eine sichere Art und Weise geschehen, die datenschutzkonform ist und die gesetzlichen Anforderungen erfüllt. Eine Möglichkeit, dies zu gewährleisten, ist der Einsatz von Vektor-Datenbanken und Open Source LLMs, die lokal auf einem Server oder in einer gesicherten Cloud betrieben werden. Im Folgenden sind einige Vector-Datenbanken aufgeführt:

Open Source Large Language Models

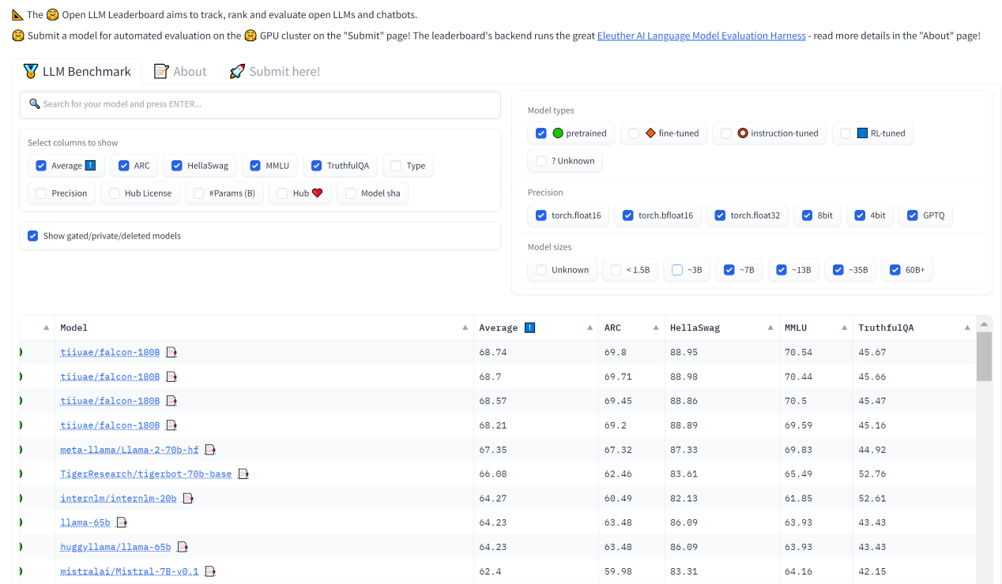

Um den Datenaustausch mit den großen Technologieplayern wie OpenAI oder Google zu vermeiden, bietet sich die lokale Nutzung von Open Source Large Language Modellen an. Derzeit entwickelt sich eine starke Open Source Community. Meta war das erste Unternehmen, das sein KI-Modell der KI-Community zur Verfügung stellte. Inzwischen sind zahlreiche Varianten entstanden. Zum Beispiel hat das Pariser KI-Startup Mistral AI, das nur fünf Wochen nach seiner Gründung über 100 Millionen Euro eingesammelt hat, im September 2023 sein erstes Open Source Large Language Model vorgestellt.[i] Wobei „groß“ hier relativ ist, denn das Modell verfügt über sieben Milliarden Parameter und ist damit von der Größe her eher bescheiden. Die Anzahl der Parameter ist ein entscheidendes Kriterium für den Vergleich von Sprachmodellen. Generell gilt: Je größer, desto besser. Größere Modelle können mehr Daten verarbeiten, mehr lernen und bessere Ergebnisse erzielen. Das derzeitige Spitzenmodell GPT-4 soll eine Billion Parameter haben. Größere Modelle benötigen jedoch mehr Rechenleistung, was ihre Entwicklung und Implementierung teurer macht. Im Leaderboard der Open-Source-LLMs, das von der Community-Website huggingface.com veröffentlicht wird, liegt das Modell „Mistral-7B“ bereits auf Platz 10. (Stand 03.10.2023)

Kontinuierliche Verbesserung

Die Optimierung des LLM ist kein einmaliger Prozess. Sie erfordert eine kontinuierliche Erweiterung des Modells mit neuen Unternehmensdaten, um sicherzustellen, dass es aktuell und effektiv bleibt. Vor allem ist eine kontinuierliche Überwachung der Qualität der LLMs enorm wichtig, wie die Stanford/Berkeley-Studie „How Is ChatGPT’s Behavior Changing over Time?“ im August zeigte: Wissenschaftler:innen verglichen GPT-4 und GPT-3.5 – und stellten Qualitätsabweichungen in beiden Versionen fest.[ii]

Darüber hinaus gibt es verschiedene Werkzeuge und Bibliotheken, die B2B-Unternehmen bei der Nutzung von LLM und Vektordatenbanken unterstützen können, wie z.B. LangChain. LangChain ist eine Python-Bibliothek, die bei der Verarbeitung von LLMs und Vektordatenbanken hilfreich sein kann. Sie bietet eine Vielzahl von Funktionen, von der Textgenerierung bis zur Textanalyse – und ermöglicht Entwickler:innen die Erstellung komplexer Anwendungen mit LLMs.

Unternehmen sollten die verfügbaren Optionen sorgfältig prüfen und diejenigen auswählen, die ihren spezifischen Anforderungen am besten entsprechen.

Fazit

Die Nutzung von Open Source Large Language Modelle bietet Unternehmen enorme Potenziale, um unstrukturierte, unternehmensinterne Daten zu analysieren. Der Schlüssel zur erfolgreichen Optimierung liegt jedoch im internen Fach- und Domainwissen des Unternehmens sowie in der effizienten Verwaltung und Integration dieser Daten mithilfe von Vektordatenbanken.

Für Führungskräfte ist es entscheidend, die Möglichkeiten von LLMs in ihrem Unternehmen zu erkennen und die erforderlichen Schritte zu unternehmen, um diese Potenziale auszuschöpfen. Dies wird nicht nur die Effizienz und Qualität ihrer Anwendungen verbessern, sondern auch einen wertvollen Wettbewerbsvorteil bieten.

[i] https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard zugegriffen am 03.10.2023

[ii] https://arxiv.org/pdf/2307.09009.pdf zugegriffen am 04.10.2023

[i] https://www.searchenginejournal.com/mistral-ai-launches-open-source-llm-mistral-7b/497387/#:~:text=Mistral%20AI%2C%20a%20burgeoning%20startup,alternative%20to%20current%20AI%20solutions. Zugegriffen am 04.10.2023

[i] https://learn.microsoft.com/de-de/azure/machine-learning/concept-retrieval-augmented-generation?view=azureml-api-2 zugegriffen am 03.10.2023

Die Kommentarfunktion ist geschlossen.